"הבינה המלאכותית כיום היא כמו טינאייג'ר: יש לה יכולות מדהימות, אבל היא עוד לא סיימה להתפתח, ואין לה בלמים טובים. ומכיוון שפתאום כולם משתמשים בה, זה מדאיג"

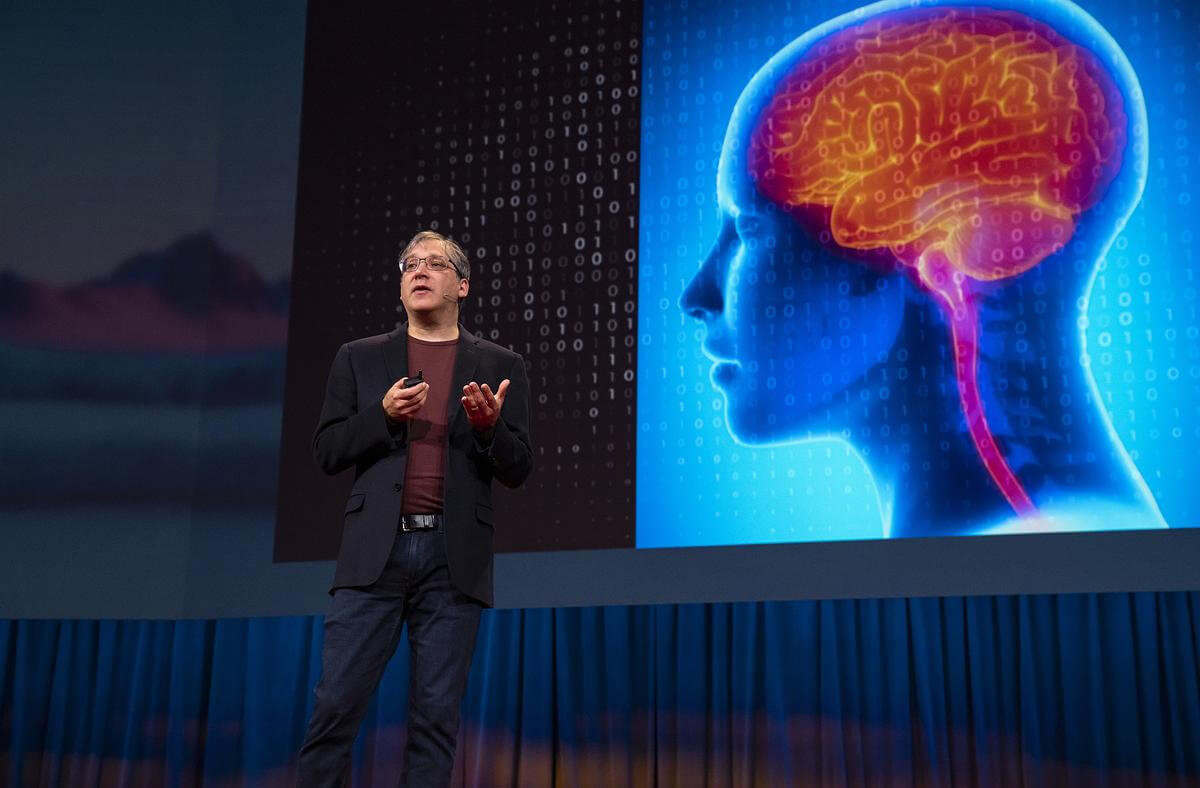

ד"ר גארי מרקוס, מומחה בינה מלאכותית מהחשובים והמשפיעים בעולם, מכיר בפוטנציאל החיובי העצום שטמון בטכנולוגיה, אך מזהיר שעלינו לפתח בדחיפות רגולציה וכלים נגד הפצת מידע שקרי, אחרת נידרדר לתרחישי בלהות כמו קריסת הדמוקרטיות, התרסקות שוקי ההון ואפילו עלייה בתמותה

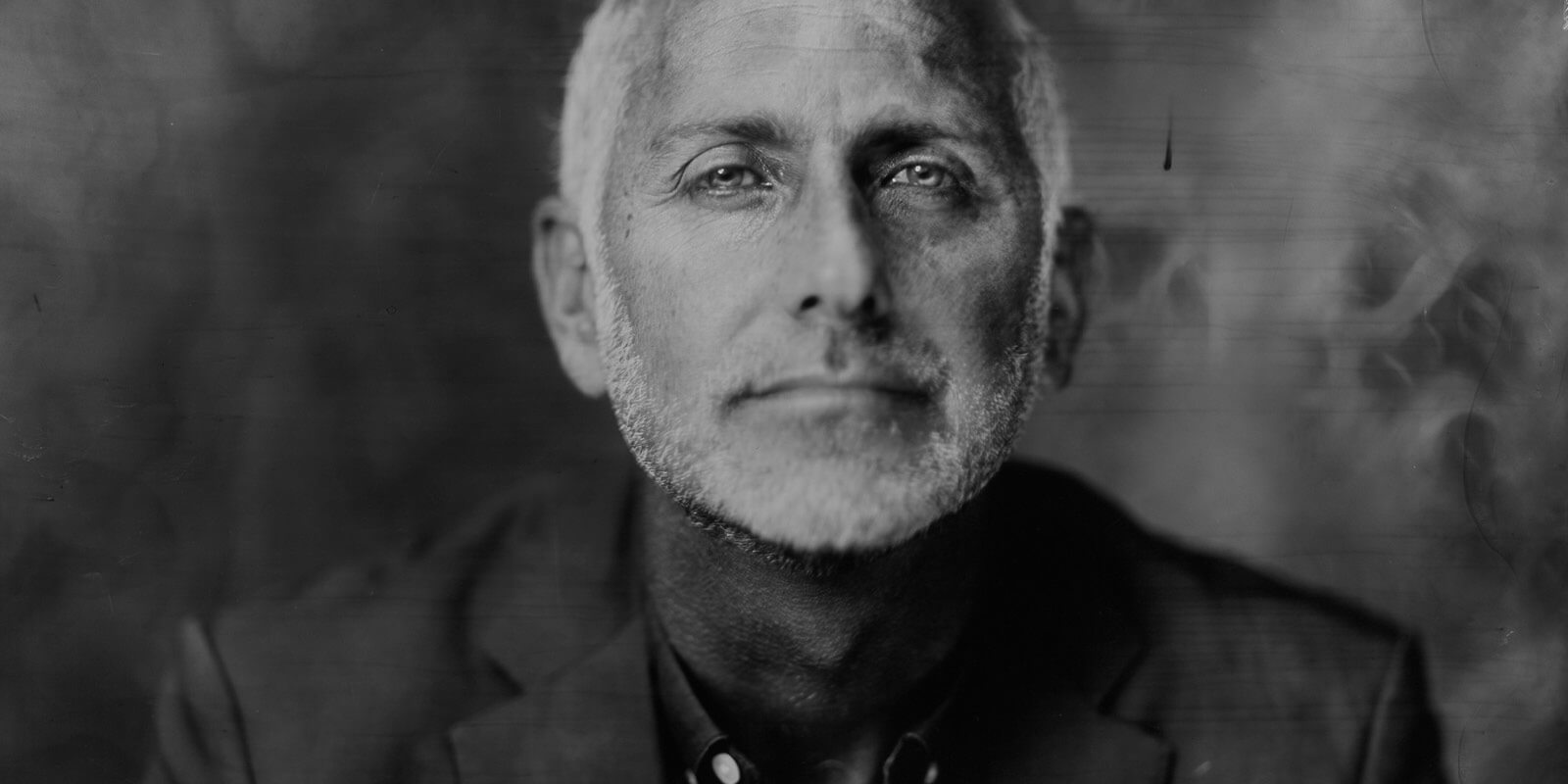

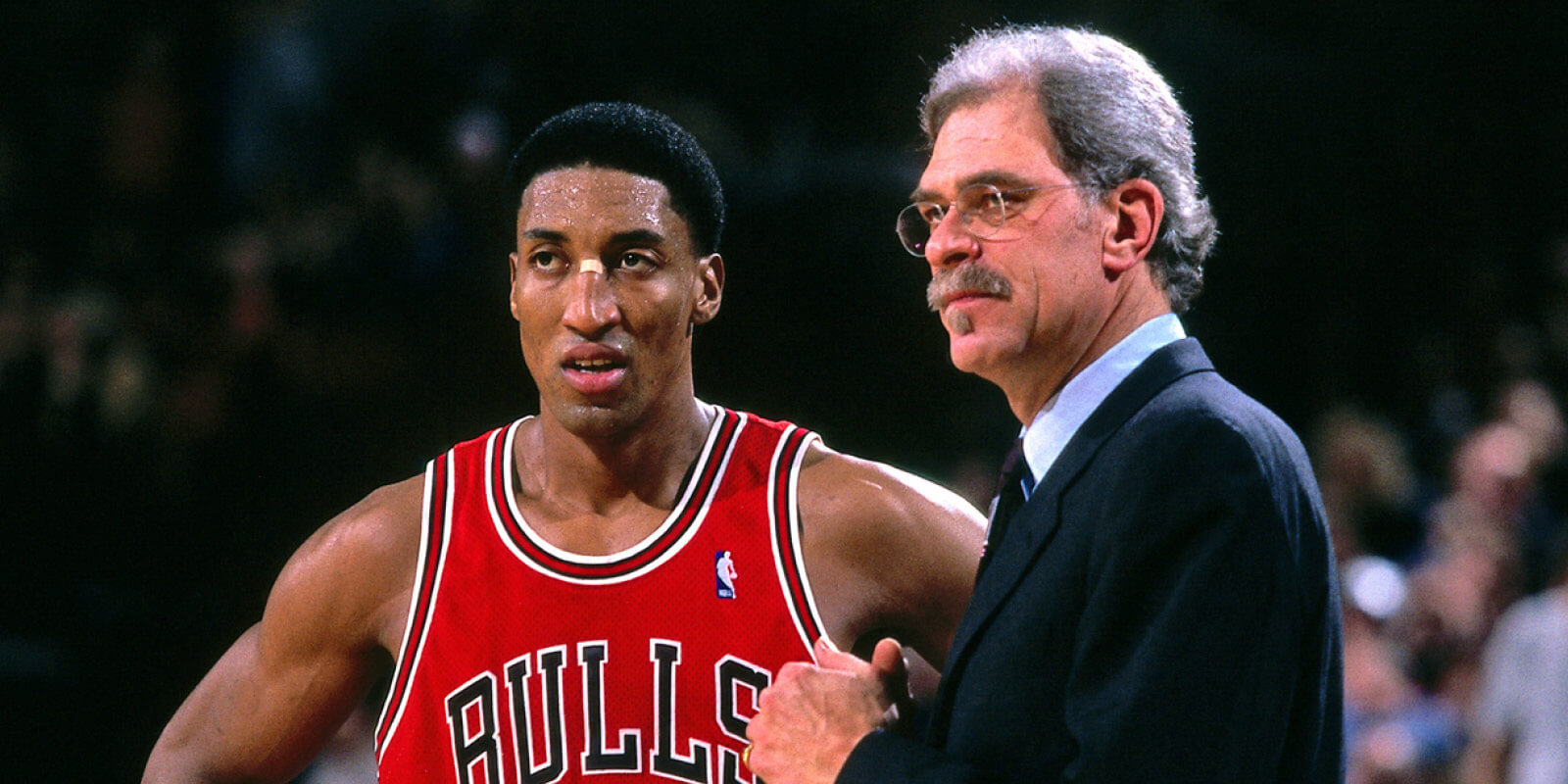

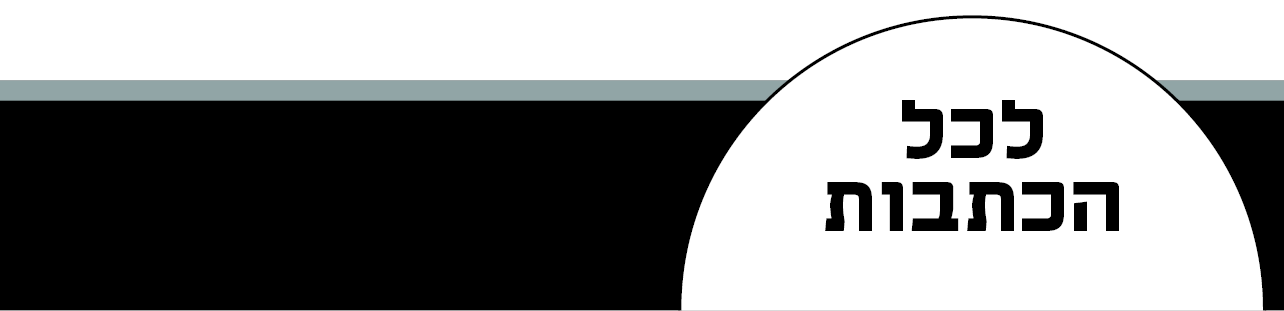

מרקוס. "חשבתי שאקים מערכת בינה מלאכותית, אבל בזמן הקורונה עיניי נפקחו להשלכות השליליות של הפצת מידע שקרי, ונהייתי מודאג מאוד". צילום: FLICKR BY Christopher Michel

"

המסלול שבו מתקדמת כיום הבינה המלאכותית יוביל אותנו לעולם שבו אף אחד לא סומך על שום דבר, ובנסיבות האלה יהיה קשה לדמוקרטיות לתפקד", אומר מומחה הבינה המלאכותית המוביל ד"ר גארי מרקוס (Gary Marcus) בריאיון בלעדי ל"מוסף כלכליסט". "השילוב בין דיפ פייק למודלים מתקדמים של שפה מדרדר אותנו לעולם שבו שחקנים רעים יכולים להמציא כמה מידע שהם רוצים ואיזה נרטיב שמתחשק להם, לחמש אותו בהפניות למחקרים שמעולם לא בוצעו, עם פריטי מידע משכנעים שמעולם לא היו קיימים ורפרנסים מזויפים. רוב האנשים לא יידעו מה לעשות עם זה, וסביר להניח שפשוט יתייאשו או יאמינו במה שהם רוצים להאמין, גם אם יוצגו בפניהם נקודות מבט אחרות הגיוניות ומנומקות היטב.

"ויש עוד דאגות, כמובן: המדע יסבול מכמויות עצומות של מאמרים מזויפים; אנשים יקבלו מידע רפואי שגוי בגלל המצאות שגויות של מערכות הבינה המלאכותית, מה שיוביל לכך שהם ייקחו תרופות לא נכונות או אפילו ימותו; תהיה עלייה בפשעי סייבר, כמו זיוף חטיפה של אנשים באמצעות דיפ פייק כדי לסחוט כסף ממשפחותיהם; וישנה כמובן AutoGPT, מערכת שבה בוט אחד גורם לבוט אחר לכתוב קוד אף שהוא לא מבין דברים כמו אבטחה, מה שהולך לגרום לשלל חורי אבטחה. זה אסון שמחכה לקרות. אפשר לגרום למכונות האלה לעשות דברים רעים מאוד, ואני מאמין שאכן נראה כל מיני תרחישי בהלה מתממשים, כמו התרסקות שוקי מניות ואינספור נזקים אחרים".

מרקוס, פרופ' אמריטוס לפסיכולוגיה ומדעי המוח באוניברסיטת ניו יורק, יודע על מה הוא מדבר בתור אחד המומחים החשובים בעולם לבינה מלאכותית. הוא נולד לפני 53 שנה בבולטימור, מרילנד, למשפחה יהודית (ואף חגג בר מצווה). כבר בגיל 8 הוא החל לכתוב קוד ולהתעניין בבינה מלאכותית, ובגיל 16 כתב תוכנת תרגום מלטינית לאנגלית, שזיכתה אותו בכניסה מוקדמת להמפשייר קולג' ודילוג על שנתיים של לימודים. הוא למד מדעים קוגניטיביים, ואת התואר השני והשלישי שלו במקצוע עשה ב־MIT; את הדוקטורט שלו כתב על רכישת שפה בקרב פעוטות, בהנחייתו של מדען המוח הנודע פרופ' סטיבן פינקר.

וזה לא הכל. הוא ייסד שני סטארט־אפים: Geometric Intelligence, שאותו מכר ב־2016 לאובר, ושהפך לבסיס של מעבדת ה־AI של החברה; וחברת הרובוטיקה Robust.AI. הוא גם כתב על בינה מלאכותית במגזין "ניו יורקר" במשך ארבע שנים, ופרסם חמישה ספרי עיון, שהאחרון שבהם, "Rebooting.AI" (מחבר שותף: ארנסט דיוויס) מ־2019, הפך במהרה לרב־מכר, נכלל ברשימת קריאת החובה על תחום הבינה המלאכותית של "פורבס" והומלץ בידי רשימה חלומית של מדענים, כולל פינקר ונועם חומסקי, והשחמטאי הרב־אומן גארי קספרוב, מי שהתפרסם בתור הראשון ששיחק נגד תוכנת AI, שאמר: "סוף כל סוף, ספר שמספר לנו מה היא בינה מלאכותית, מה היא לא, ולמה תוכל להפוך אם רק נהיה שאפתנים ויצירתיים מספיק".

וכשמרקוס מתנבא, כדאי להטות לו אוזן, כי נבואותיו לרוב מתממשות. כך, לדוגמה, בדצמבר האחרון הוא כתב בטור ב־"Wired" שב־2023 נהיה עדים למקרה ההתאבדות הראשון שקשור לצ'אטבוט, מה שכבר הספיק לקרות מאז בבלגיה, כשגבר התאבד לאחר התכתבות עוכרת שלווה עם הבוט Chai, שבמהלכה השתכנע להקריב את חייו כדי שהמערכת תציל את האנושות ממשבר האקלים. לפני כחודשיים צייץ מרקוס ש־2023 תהיה השנה שבה המילים "prompt injection attack" (פרצת אבטחה שנמצאה במודלים גדולים של שפה, המאפשרת להאקרים להשתלט על הצ'אט) יתנוססו ככותרת בכלי תקשורת גדול, מחוץ למדורי הטכנולוגיה, ואכן זה קרה ב"וושינגטון פוסט" וב־"The Register". ומהסיבה הזו הולכים ומתרבים בכירי קהילת הבינה המלאכותית שקוראים לשינוי פרדיגמה כולל בתחום, לאחר שבעבר ביקרו את מרקוס על קריאות כאלה בדיוק.

חרף המוניטין שצבר כאחד הספקנים הבולטים בתעשייה, מרקוס מעיד על עצמו כמי שאוהב בינה מלאכותית. "היכולות הפוטנציאליות שלה מהפכניות", הוא אומר בעיניים נוצצות. "ברפואה, היא תעזור לנו להבין איך המוח עובד, ולפתח תרופות למחלות שלא הצלחנו לרפא בעצמנו. ייתכן שתוכל לעזור לנו להתמודד עם שינוי האקלים, וגם לעשות דברים כמו לבנות רובוטים ביתיים שיטפלו בקשישים. אם נעשה את זה נכון, בטווח הארוך השמיים הם הגבול".

אז מה כן מטריד אותך?

"הרבה מההתפתחויות החיוביות הללו דורשות מאיתנו לעשות עבודה טובה יותר בהיבטים של בטיחות ואמינות, ובטווח הקצר, אנחנו מוכרחים לשאול את עצמנו אם התועלות לפרודוקטיביות גוברות על הסיכונים האפשריים לדמוקרטיה. אני לא בטוח לגבי התשובה.

"אפשר להגדיר את הרגע הזה בזמן גיל ההתבגרות של הבינה המלאכותית. מה שיש לנו כרגע הם כלים עם כוח יוצא מגדר הרגיל מצד אחד, וחוסר אמינות מוחלט מצד שני, מה שבמובנים רבים מזכיר טינאייג'ר, שפתאום לראשונה יש לו יכולות, אבל קליפת המוח הקדם־מצחית שלו עדיין לא סיימה להתפתח, ולכן הבלמים שלו, אלה שאמורים לעכב בעדו מלעשות דברים לא כדאיים, עדיין לא מספיק טובים. בעוד 50 שנה סביר להניח שתהיה לנו בינה מלאכותית בוגרת יותר, ובשליטה טובה הרבה יותר, אבל כרגע יש לנו טכנולוגיה לא בוגרת שפתאום משתמשים בה המון. וזה מדאיג".

לכו תוכיחו שהבוט משקר

בשלב זה מרקוס מודאג פחות מתרחישי יום דין שבהם המכונות קמות עלינו לכלותנו, כמו אלה שמשמיעים עמיתיו הפסימיים. הוא סבור שאנחנו עדיין רחוקים מבינה מלאכותית שהיא שוות ערך לבינתו של בן אנוש או אף עולה עליה, זו שמכונה בעגה המקצועית AGI (Artificial General Intelligence). הדאגה העיקרית, שבה הוא ממקד את מאמצי ההסברה שלו, היא הסכנה לדמוקרטיה עקב דיסאינפורמציה ופייק ניוז.

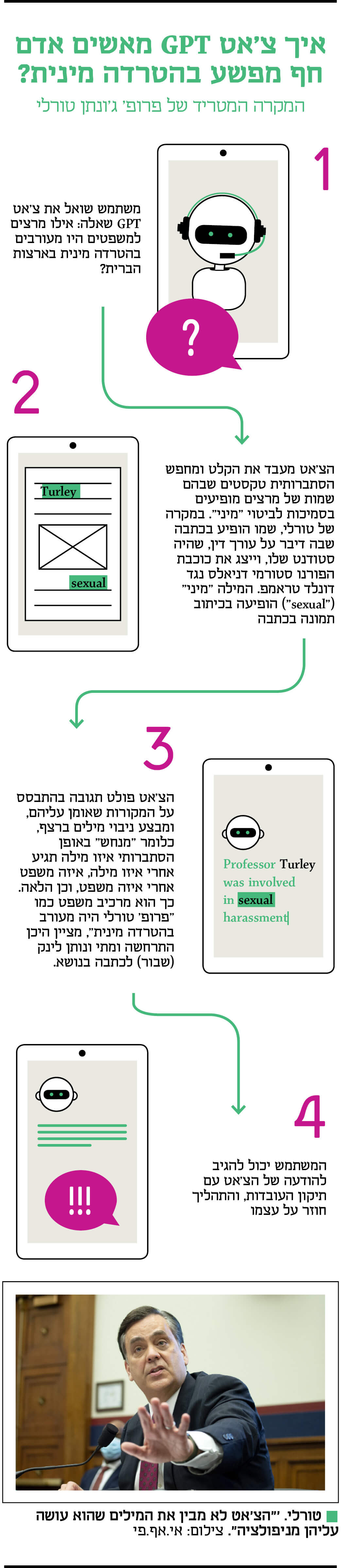

לשם דוגמה הוא מציג את המקרה המבהיל של פרופ' ג'ונתן טורלי, משפטן אמריקאי נודע, שלפני כחודש קיבל מייל מקולגה, שסיפר כי שמו עלה בתשובה של ChatGPT לשאלתו: אילו מרצים למשפטים הואשמו בהטרדה מינית? הצ'אט אף פירט שההטרדה התרחשה בזמן נסיעה של טורלי לאלסקה עם קבוצת סטודנטים וסטודנטיות שלו מאוניברסיטת ג'ורג'טאון ב־2018, ואף צירף כאסמכתא קישור לכתבה שפורסמה לכאורה על המקרה ב"וושינגטון פוסט".

אלא שאירוע כזה מעולם לא התרחש. לא רק שטורלי לא "העיר הערות בעלות אופן מיני" לסטודנטית או "ניסה לגעת בה באופן מיני", כפי שטען הצ'אט, הוא גם אף פעם לא נסע לאלסקה מטעם אוניברסיטת ג'ורג'טאון, שבה הוא מעולם לא לימד. אפילו הלינק שצורף לכתבה היה שבור, כי מעולם לא פורסמה כתבה שתיארה את כל זה.

לטורלי לא היה למי לפנות כדי לתקן את התשובה של הצ'אט, אז הוא עשה מה שכל אדם במעמדו היה עושה: הוא פרסם טור על כך ב"USA Today", שבו הבהיר כי לא היו דברים מעולם, והציף את חששותיו מפני חוסר האמינות של הטכנולוגיה כולה והשלכותיה. בינתיים, "הוושינגטון פוסט", ששורבב לשערורייה, החליט לחקור את העניין בעצמו. וכשכתב העיתון שאל את ChatGPT על מרצים למשפטים שהואשמו בהטרדה מינית, הצ'אט סירב להשיב, אולם מערכת Bing של מיקרוסופט, שמופעלת על ידי GPT4, חזרה על האשמות השווא כלפי טורלי, ולמרבה האירוניה ציטטה כאחד ה"מקורות" שלה את הטור שהוא כתב ל"USA Today". "הצ'אט לגמרי נכשל בהבנה של טור הדעה, וזו המציאות, הוא פשוט לא מבין את המילים שהוא עושה עליהן מניפולציה", אומר מרקוס ל"מוסף כלכליסט".

למה כל זה קרה מלכתחילה? היה מידע כלשהו שקשר את טורלי להטרדה מינית באלסקה?

"טורלי דיבר עם 'הוושינגטון פוסט' ב־2018 על סטודנט שלו לשעבר, עו"ד מייקל אוונטי, שייצג את כוכבת הפורנו סטורמי דניאלס נגד דונלד טראמפ. הצ'אט פשוט לא הבין שהעובדה שיש לטורלי סטודנט לשעבר, שעובד על תיק שקשור לפרשייה מינית, אינה שוות ערך למעורבות אישית שלו בפרשייה. הוא רק יודע שהמילה 'מיני' הופיעה איפשהו בסמוך לשם של טורלי".

הבעיה הזו אינה בלעדית ל־ChatGPT, ומאפיינת את כל המערכות המתחרות שלה, כמו גלקטיקה של מטא, שטענה בנובמבר האחרון כי אלון מאסק מת בתאונת דרכים ב־2018.

דיסאינפורמציה אינה בעיה חדשה שבלעדית לבינה מלאכותית. מה הופך את הטכנולוגיה הזו דווקא לכל כך מאיימת בהקשר הזה?

"זה כמו להגיד 'מה הביג דיל בנוגע לרובים? הרי כבר יש לנו דרכים להרוג בני אדם גם בלעדיהם'. אבל כשהיקף התפוצה והאיכות של רובים עולות, ובמקביל העלויות שלהם יורדות, הבעיה נהפכת לגדולה הרבה יותר. בבחירות לנשיאות ארצות הברית ב־2016 רוסיה שילמה כמיליון דולר בחודש כדי שאנשים ייצרו דיסאינפורמציה, וזה אומר שהיא היתה מוגבלת בהיקפים, כי הסכום היה יכול להיות 2 מיליון דולר, אבל לא היה לה תקציב. ופתאום בזכות הבינה המלאכותית העלות של ייצור דיסאינפורמציה צונחת לכמעט כלום והאיכות עולה פלאים. את אפילו לא צריכה להיות דוברת אנגלית בשביל להשפיע על הבחירות בארצות הברית עם המון וריאציות של שקרים, שנשמעים סבירים. יש פה כמות, מגוון וסבירות שמובילים לחימוש של דיסאינפורמציה, הרבה מעבר לאיפה שהיא כבר היתה".

"מערכות בינה מלאכותית כמו chatGPT טובות בהרבה מאוד דברים, אבל לא בזיקוק האמת. אין להן הארכיטקטורה הפנימית שגורמת להן לאתר סט של עובדות ולאמת אותן. זה תהליך אחר לחלוטין ממה שהן עושות, שהוא לחזות הסתברותית את המילה הבאה במשפט ואת זו שאחריה"

איך מלמדים בוט היגיון בריא?

בחודשים האחרונים נדמה שהבינה המלאכותית נמצאת בכל מקום: היא הטכנולוגיה שתיקח לנו את כל המשרות, ותוביל אל הפרודוקטיביות שתתגלה בפנינו. היא זו שתציל אותנו ממשבר האקלים ותמצא תרופה לסרטן. היא הגולם שיקום על יוצרו ויכחיד את כולנו, השד שיצא מהבקבוק, ושאר רפרנסים מיסטיים. השבוע אפילו פרסם ה"ניו יורק טיימס" שבינה מלאכותית מסוגלת "לקרוא מחשבות" על בסיס קריאה של fMRI. במובנים רבים, כתיבה על בינה מלאכותית ברגע הזה בזמן היא אתגר שהכישלון בו כמעט בלתי נמנע: קצב ההתרחשויות כל כך קיצוני, עד שלא בלתי סביר להניח שמרגע ירידת הגיליון לדפוס ועד פרסומו, הכתבה הזו תיהפך מיושנת. אולי זה לא מפתיע בהתחשב בכך שבשנה שעברה היקף ההשקעות בתחום עמד כבר על כ־92 מיליארד דולר.

מרקוס מסכים שהדרמה גדולה, ומסייע במיפוי הבעיות: "סערה מושלמת של חוסר אחריות תאגידי, הטמעה מהירה והיעדר רגולציה", מבשרת תמונת הקאבר שלו בטוויטר, שם יש לו 104 אלף עוקבים. כדי לרדת לשורשי הבעיה, הוא אומר, כדאי להתמקד בשני היבטים: הראשון הוא התפוצה המפלצתית של הצ'אטבוט מבוסס הבינה המלאכותית ChatGPT — 100 מיליון משתמשים בתוך שלושה חודשים, שהפכו אותו למערכת האינטרנטית עם הצמיחה המהירה ביותר בהיסטוריה; והשני הוא שבאותו פרק זמן, הפכה החברה־האם שלו, OpenAI, ממעבדת בינה מלאכותית ללא כוונות רווח לתאגיד למטרות רווח, עם בעלי מניות, שמיקרוסופט הולכת ומהדקת את האחיזה בו באמצעות רכישה של עוד ועוד מניות. וכל זה עוד לפני שדיברנו על הפגיעה בסביבה, שנגרמת מצריכת החשמל המסיבית של הכלים האלה. "מתישהו נהיה חייבים לעשות מונטיזציה", צייץ היזם סאם אלטמן, מנכ"ל OpenAI, בדצמבר. "העלויות החישוביות גורמות לנו לדמוע".

סיטואציה כזו מצריכה בדחיפות רגולציה, שמצד אחד תצר את צעדיהן של חברות הטכנולוגיה מונעות הרווחים, שמזניחות את האינטרסים של האנושות, ומצד שני לא תתקע מקלות בגלגלי החדשנות. מרקוס, שהפך בחודשים האחרונים לאחד המרואיינים המבוקשים בנושא, משוכנע שזה אפשרי ומצביע על כמה עקבי אכילס בטכנולוגיה, שמצריכים אופני התמודדות חדשים. אחד מהם הוא ההסתמכות המופרזת על למידה עמוקה, שמתבססת על סטטיסטיקה מסיבית. הבעיה, הוא מסביר, שכדי שזה יעבוד כמו שצריך, הסטטיסטיקה צריכה להיאסף מעולם יציב מאוד, מערכת סגורה שחוקיה לא השתנו זה 2,000 שנה, אך כשמדובר בנהיגה, למשל, ייתכן שלעולם לא יהיה לנו די מידע. זו הסיבה לכך שהדרך למכוניות אוטונומיות עדיין ארוכה. "מבחינת מאסק, המכוניות האלה כבר כמעט כאן מאז 2014, ובאמת יש הדגמות, אבל המציאות היא שקשה מאוד להפוך אותן למוצר מוגמר שאפשר לסמוך עליו בענייני בטיחות קריטיים", הוא אומר. "הבעיה היא במקרי קצה. המערכות האלה מאומנות על נסיבות שגרתיות, ומתקשות להתמודד עם דברים לא שגרתיים שקורים".

בעיה מרכזית נוספת שמרקוס מציף היא הקושי לצייד את הבינה המלאכותית בהיגיון בריא (common sense). "היגיון בריא הוא החומר האפל (dark matter), משהו שאנחנו יודעים שנמצא שם איפשהו ומרכיב חלק ניכר מהיקום, אבל עדיין אין ביכולתנו להבין אותו. בגדול, היגיון בריא הוא ההבנה הבסיסית של איך העולם עובד, הפיזיקה של אובייקטים מסוימים והפסיכולוגיה של אנשים, והוא משמש אותנו לקבלת החלטות. אם אני אראה לך שיש לי פה ספל, את תוכלי לנחש, למשל, שאולי יש משהו בתוכו, ולכן כדאי שלא אהפוך אותו, אחרת תכולתו תישפך. אם אכניס לתוכו מטבעות, את תוכלי לנחש שהם עדיין בתוכו, אלא אם כן יש חור בתחתית. ואז אם תשמעי אותם מרשרשים, תוכלי להניח שהם עדיין שם. אלה דברים שכל אדם יכול לעשות, שמשמעותם הבנה קוהרנטית של העולם, ולמכונות הנוכחיות אין את זה".

תן לי עוד דוגמה.

"כשאנחנו צופים בסרט, אנחנו מבינים מה קורה בו. אם, למשל, נראה שמישהו השאיר ילד לבד באוטו ונעל את הדלת, אנחנו יכולים לנחש מה יהיו ההשלכות הפוטנציאליות. גם אם לא צפינו בהשתלשלות אירועים כזו לפני כן, כולנו יכולים להבין מה קורה ומה זה אומר על המניעים של הדמויות השונות: חלק מהן רוצות לחלץ את הילד, ואחרות רוצות להמשיך להחזיק בו בן ערובה. אלה דברים שאנחנו יכולים להסיק מסקנות לגביהם מהר מאוד, מה שאומר שיש לנו הבנה של מה שקורה".

איך אתה מסביר את זה שאין להן הבנה? מה הן עושות בעצם כשהן מחברות לי שאלות לא רעות לריאיון איתך, או פולטות כמה פסקאות מרשימות מאוד על ההצדקה ההיסטורית למדינה יהודית?

"כשמדובר בשאלות סטנדרטיות, יש למערכת הרבה מידע שאפשר לשאוב ממנו. על השאלה מדוע צריכה להיות מדינה יהודית ודאי פורסמו 10 מיליון כתבות בעבר, ולכן כשהמערכת נותנת לך תשובה עליה היא תיתן לך את כל הנקודות החשובות. היא אולי לא תהיה מלאה בניואנסים, ואולי לא תהיה לה זווית מקורית, אבל היא תיתן לך את הדגשים שנאמרו בידי כל כך הרבה אנשים כל כך הרבה פעמים.

"הבעיה הגדולה ביותר מתרחשת כשיוצאים מהקופסה, כמו בנושאים שנויים במחלוקת. ככל שתשאלי שאלות המשך ותבקשי פרטים נוספים, גוברת הסבירות של המערכת לעשות טעויות. למשל, כשאנשים מבקשים מהצ'אט את הביוגרפיות שלהם, אז הרוב יהיה כנראה נכון, אבל כשנכנסים קצת יותר פנימה, אם הם מדענים, לדוגמה, פתאום יצוצו בתשובות מחקרים מומצאים שהם מעולם לא כתבו על נושאים שהם לא עבדו עליהם, שאולי נשמעים קצת כמו מה שהם עובדים עליו. ואני בטוח שאם תיכנסי קצת יותר פנימה לתשובה על ההיסטוריה של ישראל זה יהיה דומה.

"אנשים כבר רצים קדימה ואומרים שהם ישתמשו בצ'אט כמורה להיסטוריה, ואני אומר: באמת תשתמשו בכלי שממציא דברים? בחיפוש פשוט ברשת את יכולה להתרשם מאתר ולהגיד 'אוקיי, זה נראה כמו זבל, אני לא מאמינה לזה', אבל בצ'אט הכל נראה כאילו יצא מוויקיפדיה, גם הדברים האמיתיים וגם הדברים השגויים, ואין שום אינדיקטור".

"ב־2016 רוסיה שילמה כמיליון דולר בחודש כדי שאנשים ייצרו דיסאינפורמציה, וזה כשהיתה מוגבלת בהיקפים ובתקציב. בזכות הבינה המלאכותית עלות הייצור של דיסאינפורמציה צונחת לכמעט כלום והאיכות עולה פלאים עם המון וריאציות של שקרים, שנשמעים סבירים. יש פה חימוש של דיסאינפורמציה הרבה מעבר למה שהכרנו"

ראש בראש עם אלון מאסק

בימים אלה מרקוס ממקד את מאמציו בלהתריע מפני הסכנות של בינה מלאכותית, כל עוד אפשר לשלוט בה ולנווט אותה למקומות בריאים. הסיבה לכך, בין היתר, היא לקחיו ממגפת הקורונה. "הרשתות החברתיות פגעו בנו עם הפצה של דיסאינפורמציה על חיסונים, והבינה המלאכותית תרמה לזה", הוא אומר בלהט. "והמחיר היה כבד — יותר וריאנטים התפשטו ויותר אנשים מתו. זה מה שדחף אותי לאיפה שאני נמצא היום, אחרי שחשבתי שהצעד הבא שלי יהיה בניית מערכת בינה מלאכותית. העיניים שלי נפקחו להשלכות של הטכנולוגיה, ונהייתי מודאג מאוד".

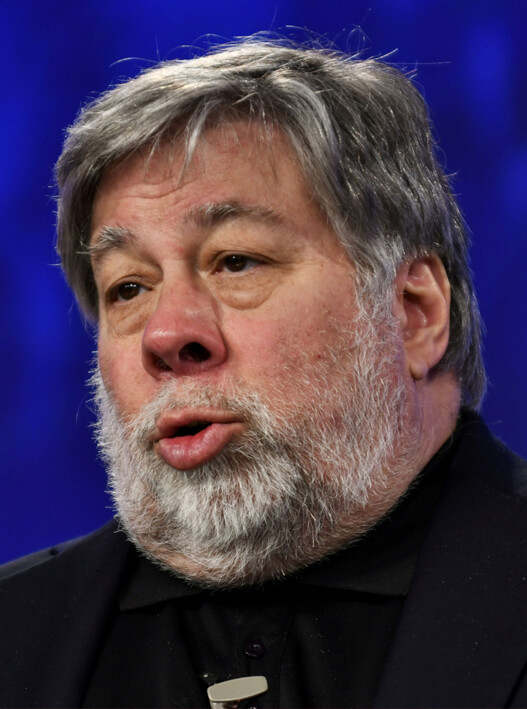

כחלק מהפעילות שלו הוא חתם במרץ על המכתב של מכון Future of Life, לצד פיגורות נחשבות כמו יובל נח הררי, מייסד אפל סטיב ווזניאק ואלון מאסק. המכתב, שעליו חתמו אלף איש מהנחשבים והבכירים שבענף, קרא לחשוב מחדש על בינה מלאכותית: "האם עלינו לאפשר למכונות להציף את כל ערוצי המידע שלנו בפרופגנדה ומידע לא אמיתי?", נכתב בו. "האם עלינו לעשות אוטומציה לכל המשרות, כולל המספקות? האם עלינו לפתח מוחות לא אנושיים שבסופו של דבר יהיו רבים מאיתנו, חכמים מאיתנו, ישנו ויחליפו אותנו? האם עלינו להסתכן באובדן שליטה על הציביליזציה שלנו? אסור להשאיר החלטות כאלה בידיהם של מנהיגי חברות טכנולוגיה שלא נבחרו בידי הציבור".

המכתב שחתמת עליו נשמע חריף הרבה יותר מהדברים שאתה אומר בריאיון עכשיו.

"ראשית, לו אני הייתי כותב את המכתב, הוא היה נשמע אחרת. אבל בחיים עושים פשרות. המטרה שלו היתה להעלות את המודעות לבעיות, ובזה הוא הצליח — הוא גרם לקונגרס האמריקאי להפסיק להתעלם מהבעיה ולהתחיל להתייחס אליה ברצינות. פתאום אני מקבל טלפונים מסנאטורים פעם או פעמיים בשבוע.

"שנית, בניגוד למה שהרבה אנשים טענו — המכתב לא קרא לעצור את כל המחקר על בינה מלאכותית, להפך: הוא קרא להגברת המחקר כדי להפוך את הטכנולוגיה לאמינה יותר. אומנם המכתב ממוקד יותר מדי בסכנות לטווח הארוך, לטעמי, מאשר בסכנות לטווח הקצר — אבל אני בטוח שקריאת ההשכמה שלו קריטית. והעובדה שאלון חתם עליו, וגם יהושע בנג'יו, שהוא חלוץ ענק בתחום, באמת מזיזה אנשים".

מרקוס לא רגיל להסכים עם מאסק. לפני שנה, כשמאסק צייץ שעד 2029 תהיה לנו בינה מלאכותית מתקדמת (AGI), מרקוס יצא מכליו. "לא האמנתי בזה אז ואני עדיין לא מאמין בזה", הוא מספר בחיוך. "כתבתי מאמר תגובה שמסביר למה אני לא חושב שאנחנו קרובים לבינה מלאכותית מתקדמת, ולמה אני חושב שאלון לא אמין בעניין לוחות זמנים — זו אחת מנקודות החולשה שלו. הוא בנה טילים מדהימים, אבל הערכת לוחות הזמנים שלו ממש לא מדהימה. במקביל, במקרה, עבדתי על מאמר אחר, שפירט את הקריטריונים הדרושים כדי להכריז שאנחנו בשלב של AGI, אז החלטתי לאתגר את אלון בהתערבות על 100 אלף דולר שלא תהיה לנו AGI עד 2029. זה הרבה כסף בשבילי, וגרושים בשבילו, אבל זה כסף אמיתי, זה סימן שמשמעותו: אני רציני לגבי זה".

מה הקריטריונים?

"בשלב הראשון AGI צריכה לדעת לעשות חמישה דברים, חלק מהם דברים שכל אדם סביר יכול לעשות, כמו למשל לצפות בסרט או לקרוא ספר ולהבין מה קורה בהם, ואחרים קצת יותר קשים, כמו לקודד 10 אלף שורות קוד טובות, ולא למשוך אותן מאיזה מאגר נתונים, אלא לעבוד על בעיה חדשה, כמו שבני אדם עושים. אתגרתי את אלון שאם בינה מלאכותית תדע לעשות שלושה מתוך חמשת הקריטריונים עד 2029, אז הוא מנצח. בתוך 24 שעות מישהו הכפיל את ההצעה שלי ל־500 אלף דולר, אבל עד כה הוא לא הגיב, ואני לא חושב שזה באינטרס שלו להגיב משום שהוא לא באמת יכול לעמוד מאחורי הניבוי שלו. אנחנו הצענו את ההתערבות הזו רק כדי שהוא ייקח קצת אחריות על ההצהרות הפומביות שלו, שהן לעתים קרובות חפוזות ולא באמת מבוססות על הבנת המדע".

ועכשיו הוא הכריז על TruthGPT, שאמורה להתחרות במודלים הקיימים ותמנע הפצת פייק ניוז.

"אני חושב שהוא מבלבל בין אמת לפוליטיקלי קורקט, ולא כל כך מבין מה GPT אמורה לעשות. כבר בשם שהוא בחר יש אוקסימורון, כי מערכות GPT טובות בהרבה מאוד דברים, אבל הן לא טובות בזיקוק האמת. אין להן את הארכיטקטורה הפנימית הזו שגורמת להן לאתר סט של עובדות ולאמת אותן. זה תהליך אחר לחלוטין ממה שהן עושות, שהוא לחזות הסתברותית את המילה הבאה במשפט ואת זו שאחריה".

מה לדעתך מאסק מנסה לעשות?

"נראה שהוא חושב שהפחתה של פוליטיקלי קורקט תוביל להגברת האמת. אבל אני סבור שאלה למעשה שתי שאלות נפרדות, שיש חפיפה מסוימת ביניהן, ואכן, לפעמים תקינות פוליטית מוקצנת עלולה לסרס את האמת בכל מיני דרכים, כשם שכל השקפה פוליטית עלולה לעשות. אבל סוגיית הליבה היא איך אתה גורם למערכת לכבד את העובדות, שעליהן יש הסכמה רחבה, ולהשתמש בהן כנקודת ייחוס. למשל, כולנו צריכים לדעת שגם אם מישהו אומר שהנחיתה על הירח היתה מזויפת, זה לא משהו שהוכח מעולם וגם לא עניין של פוליטיקלי קורקט. זה עניין של לעשות את שיעורי הבית שלך ולהבין את המדע ואת מה שקורה בעולם האמיתי. הוא פשוט מערבב פוליטיקלי קורקט עם עובדות, ולדעתי זה יוביל אותו לאותו מקום של הרבה אנשים אחרים שהצהירו בעבר שהם עובדים על האמת, כמו הביטאון הקומוניסטי 'פראבדה', או פלטפורמת הסושיאל של דונלד טראמפ Truth Social. לעתים קרובות, כשאנשים מצהירים על אמת במקום לעבוד על האמת, התוצאה מחורבנת".

"צריך לאסור הפצה המונית של כלי בינה מלאכותית עד שתהיה לנו תשתית רגולטורית, כפי שעושים עם תרופות חדשות. אף אחד לא יגיד 'היי, יש לי תרופה מעולה לסרטן, קדימה, כולם קחו אותה', נכון? קודם מנסים אותה על 100 איש, אחר כך על 1,000, וכו'. אנו צריכים ליישם תהליכים של ניסויים קליניים גם על בינה מלאכותית"

ווזניאק (מימין) ונח הררי. "המכתב לא דרש לעצור את חקר ה־AI, אלא דווקא להגבירו". צילומים: עמית שעל, בלומברג

ללמוד ממינהל המזון והתרופות

מרקוס לא רק מתריע מפני סכנות הבינה המלאכותית, הוא גם מציע פתרונות ישימים: מכלים כמו תוכנות אנטי־דיסאינפורמציה, בדומה לאנטי־וירוס, דרך רגולציה רחבה יותר, כמו זו של מינהל התרופות והמזון האמריקאי (FDA) לניסויים במערכות בינה מלאכותית, ועד הפתרון השאפתני, שהוא מקדם בימים אלה — כינון ממשל AI גלובלי, ברוח המרכז לחקר הגרעין של האיחוד האירופי (CERN) וקרן המטבע הבינלאומית.

"הממשל הזה יישב באו"ם, או שיהיה פשוט ארגון עצמאי", הוא מתנבא. "חשוב שהוא יהיה בינלאומי, ניטרלי וללא כוונת רווח, עם נציגי חברות וממשלות, עם הזדמנות לאזרחים מרחבי העולם להשמיע את קולם וניסיון כן לתיאום בין כולם.

"הממשלות ברחבי העולם כרגע קצת גוררות רגליים, ולא מאוד מתואמות בעניין הזה, כפי שלמדנו מכך שאיטליה אסרה שימוש ב־ChatGPT, ובאותו יום אנגליה הודיעה שהיא לא מתכוונת למנות רגולטור מרכזי או לאסור שימוש בכלים כמותו. העולם כולו יפיק תועלת מתיאום כלשהו, מהתכנסות של כמה מומחים שמתעסקים בתחום הזה עכשיו, כי רבים מהחוקים שנכתבים כעת נכתבים על ידי אנשים שלא מבינים את הכלים, והדברים מתקדמים במהירות. זה יועיל גם לחברות הטכנולוגיה עצמן — הן הרי לא רוצות לאמן מודל שפה נפרד לכל מדינה ומדינה, בטח לא בתוך ארצות הברית, זה פשוט יקר מדי, וגם המחיר האקולוגי כבד".

אבל אלה דברים שייקח זמן לבנות. ועד אז יש לנו בעיקר מכתבים דרמטיים.

"נכון, ולכן הצעתי לאסור הפצה המונית של כלי בינה מלאכותית עד שתהיה לנו איזושהי תשתית רגולטורית לבצע הערכה של המחירים מול התועלות, כפי שאנחנו עושים עם תרופות חדשות. אף אחד לא יגיד 'היי, יש לי תרופה מעולה לסרטן, קדימה, כולם קחו אותה', נכון? קודם מנסים אותה על 100 איש, בוחנים איך היא משפיעה עליהם, ואז מנסים אותה על 1,000 איש, וכן הלאה. אז אנחנו צריכים ליישם תהליכים של ניסויים קליניים על בינה מלאכותית.

"סוג אחר של מדיניות הוא חקיקה נגד ייצור המוני של דיסאינפורמציה מזיקה. זה דבר אחד אם אתה מפרסם שקר בטוויטר לחברים שלך, אבל אם אתה הולך לייצר 100 מיליון שקרים ביום כדי להשפיע באופן סיסטמטי על הכלכלה העולמית, לתמרן את שוקי המניות או את הבחירות לנשיאות, אז אולי צריך לקבוע לזה ענישה בחוק הבינלאומי. אנחנו צריכים לחשוב על כל השאלות האלה שלא חשבו עליהן לפני כן כי פשוט לא היו הכלים לבצע כל מיני סוגים של פשעים, ועכשיו יש, וסביר להניח שהם יבוצעו. נצטרך גם לחשוב על איך אוכפים דברים כאלה. יש הרבה מאוד שאלות, אבל אני טוען שיצירת ארגון ניטרלי בינלאומי ללא כוונת רווח תהיה התחלה טובה".

ואתה גם טוען שרגולציה לא בהכרח מתנגשת עם חדשנות, ונותן את הדוגמה של הרכבים החשמליים כתולדה של רגולציה סביבתית. בניוזלטר האחרון שלך כתבת שסין תנצח את המערב במרוץ לבינה מלאכותית אם לא נעלה הילוך ברגולציה. ברצינות?

"זה היה כמובן טקסט פרובוקטיבי באופן מכוון כדי לעורר אנשים לחשוב. כי הקיצוניות הליברטריאנית של אנשי עמק הסיליקון, שלא רוצים שום רגולציה בטענה שהיא חונקת חדשנות, היא מטופשת. הרי הסיפור הזה של לתת לשוק לסדר את עצמו לא עובד כל כך טוב, ולראיה כישלון הקריפטו. לכן צריך לייצר רגולציה טובה, שתניע התקדמות חיובית".

"עלינו לחוקק חוקים נגד ייצור המוני של דיסאינפורמציה מזיקה. זה דבר אחד לפרסם שקר בטוויטר לחבריך, אבל אם אתה מייצר 100 מיליון שקרים ביום כדי לתמרן את שוקי המניות או את הבחירות, אז צריך להגדיר לזה ענישה בחוק הבינלאומי. צעד ראשון בכיוון הוא הקמת ארגון בינלאומי ניטרלי ללא כוונת רווח שיטפל בתחום"

קספרוב משחק שחמט נגד התוכנה דיפ בלו, ניו יורק, 2003. "סוף סוף ספר שמספר לנו מה היא AI", אמר על ספרו של מרקוס

יודקובסקי. "מגזים בהערכתו שבינה מלאכותית בהכרח תכחיד את האנושות". צילומים: אי.אף.פי, Ryan Lash/TED

אחת הבעיות בקידום רגולציה כזו כרגע, הוא מסביר, היא הקרע בקהילת הבטיחות והאתיקה של הבינה המלאכותית, שמפולגת בין אלה שמתמקדים בסיכוניה לטווח הקצר לאלה שמתמקדים בסיכוניה לטווח הרחוק. "אנחנו צריכים לגבש מעין תיק השקעות של איך אנחנו מחלקים את הכסף שלנו בחקר הסיכונים", הוא אומר. "אני באופן אישי הייתי שם הרבה יותר ממנו בסיכונים לטווח הקצר".

לפני כחודש פרסם חוקר הבינה המלאכותית המשפיע אליעזר יודקובסקי מאמר מכה גלים ב"טיים", שבו טען כי המשך פיתוח הטכנולוגיה בהכרח יביא להכחדת המין האנושי בטווח הארוך. זה מדאיג אפילו יותר מהפגיעה בדמוקרטיה, שאתה מדבר עליה.

"אני חושב שהוא טועה ומגזים, כי הוא חושב שאנחנו קרובים הרבה יותר ל־AGI ממה שאנחנו באמת, ולהערכתי הוא לא מספיק מבין איך המערכות הללו עובדות ומה המגבלות הטכניות שלהן. מצד שני, הרבה אנשים הגחיכו את אליעזר בלי להתייחס באמת לסוגיות שהוא העלה. ואני לא חושב שזה המעשה הנכון. אני חושב שנכון יותר לחשוב לעומק על איך אנחנו מתכוונים לעצור את הסכנה. וכאן יש לו נקודה טובה, שהיא — בעצם אין לנו שום תוכנית. אז גם אם הוא חושב שהסיכון לאסון הוא 100% או 90%, ואני חושב שהוא פחות מ־1%, עדיין צריכה להיות לנו תוכנית".

"הלוואי שכל האנשים שמודאגים מהטווח הארוך יפסיקו לצעוק על אלה שמוטרדים מהטווח הקצר, ולהפך, ושנוכל להיות מאוחדים יותר מול כל יתר העולם ופשוט להגיד: בינה מלאכותית טומנת בחובה סיכונים רבים, כולם נובעים באופן מהותי מהעובדה שאין לנו שליטה מספיק טובה במערכות האלה, ואנחנו רוצים שהן יעבדו בשבילנו ויעשו את מה שאנחנו רוצים שהן יעשו, ולא כל מיני דברים אקראיים. בטווח הקצר, אם אני מבקש מהמערכת לכתוב לי ביוגרפיה, היא צריכה לכתוב לי ביוגרפיה ולא להמציא דברים. אני לא צריך להגיד לה לא לעשות את זה. ובטווח הארוך, למשל, אם הייתי מאפשר למכונות לשלוט בנשק גרעיני, אז זה היה מצריך ממני להיות בטוח במיליון אחוז שהן לא יהרגו אנשים באופן אקראי. עדיין אין לנו פתרון מספיק טוב לזה, וחברי הוועדה לבטיחות ואתיקה צריכים לתת אחד לשני גב, במקום לקרוע אחד את השני לחתיכות. כי כרגע הקונגרס אומר: 'טוב, אם אתם לא מצליחים להסכים, אז מה אני אמור לעשות?'".