בתמונת ראי לרובוטים "הטובים" ניצבים "הרוצחים". כאשר צבאות בעולם, מסין דרך ארה"ב ועד ישראל, מתחילים לפרוס רובוטים חמושים הנהנים ממידה של אוטונומיות, עולה החשש מפני הרגע שבו רובוטים יקבלו את ההחלטה מי ימות ומי יחיה בקרב. איך יתנהל הפיקוח עליהם, והאם אנו בדרך למהפכה השלישית בלוחמה אחרי אבק שריפה וגרעין — הנשק האוטונומי

ויקי אוסלנדר

"

טכנולוגיה אינה טובה ואינה רעה, וגם אינה ניטרלית". זה אולי החוק הראשון המפורסם ביותר של ההיסטוריון האמריקאי מלווין קרצנברג. ב־1986 הוא ידע להסביר את מה שהיום קשה להכיל – מערכת היחסים של טכנולוגיה עם הסביבה היא כזו שלפיתוחיה יש לעתים קרובות השלכות סביבתיות, אנושיות וחברתיות שחורגות הרבה מעבר למטרות המיידיות של הפיתוחים. כלומר לטכנולוגיה יכולות להיות תוצאות שונות לחלוטין כשפורסים אותה בהקשרים אחרים. לכן היכן שרובוטים יכולים לסייע למין האנושי לשגשג ולפרוח, להסיר מאיתנו מטלות יומיומיות מעיקות כמו סידור כלים מלוכלכים במדיח, הם יכולים בהקשר אחר, למשל מלחמה, לפגוע או להגן בהיקפים גדולים. ערכם של רובוטים תמיד תלוי הקשר.

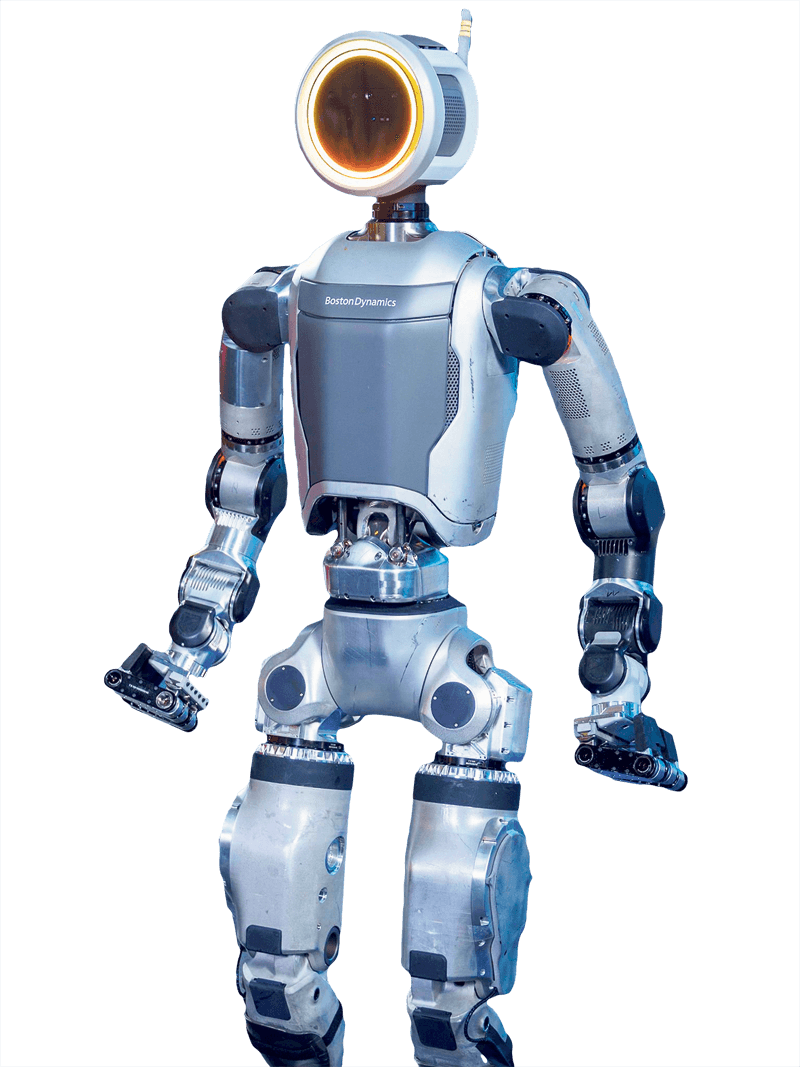

כך, במהלך תרגיל "דרקון הזהב 2024" במאי הציג צבא סין לעולם את הרובוט הרוצח החדש שלו. על המכונה שדומה בצורתה לשלד כלב מכני הותקן נשק אוטומטי, ולפניו מצלמה קטנה מנחה. בסרטון שפרסם הצבא רואים את הרובוט מוביל יחידת חיילים אל בניין, לכאורה בכוחות עצמו וללא יד מנחה — באופן אוטונומי. הצבא הסיני לא לבד. כבר ב־2020 חיל האוויר האמריקאי הדגים את השימוש שלו בכלבים רובוטיים כחוליה במערכת ניהול הקרב המתקדמת שלו, אחד מתוצרי תוכנית פיתוח נשקים אוטונומיים שניהלה ארה"ב בארבע השנים קודם לכן בהיקף של 18 מיליארד דולר. את הכלב הרובוטי הסיני פיתחה Unitree Robotics הסינית. זהות החברה חשובה מכיוון שבאוקטובר 2022, היא וחברות מובילות נוספות, לרבות בוסטון דיינמיקס ו־Agility, חתמו על מכתב פתוח שבו הצהירו כי לא יסכימו לחמש את מוצריהן, זאת אחרי תצוגה של Ghost Robotics שבה חשפה רובוט כלב אוטונומי חמוש בפיתוחה. "אנו מאמינים שהוספת כלי נשק לרובוטים המופעלים מרחוק או אוטונומית ושמסוגלים לנווט למקומות שלא היו נגישים בעבר, שבהם אנשים חיים ועובדים, מעלה סיכונים חדשים של נזק ובעיות אתיות חמורות", כתבו והתחייבו "לא להוסיף טכנולוגיית נשק" בעצמן או "לתמוך באחרים לעשות כן". שנה וחצי חלפה, ו־Unitree עושה מה שהתחייבה שלא לעשות.

ב־20 השנים האחרונות קמו ארגונים רבים ללא מטרות רווח להיאבק במה שהם מכנים "רובוטים רוצחים" או באופן רשמי LAWS (Lethal Autonomous Weapons Systems). החשש היה תמיד מפני התקדמות טכנולוגית מסוג זה, שבה רובוטים יקבלו את ההחלטה האוטונומית לבחור מטרות ולהשמיד אותן. אוטונומיה מסוג זה, טענו, תעצים עוד את הדה־הומניזציה שמתרחשת בין כה וכה במלחמה, תצייד את הצדדים בנשקים שיסבו נזק גדול יותר, בעלות קטנה יותר, ותהפוך מלחמות לגרועות יותר. "השאלה האמיתית היא לא בין שני הקצוות — אוטונומיה מלאה או ללא אוטונומיה — אלא איזו מידה של אוטונומיה אנחנו מוכנים לתת למכונות כי אנחנו כבר נותנים להן אוטונומיה מסוימת", אומר ד"ר אורן עציוני, שהיה מנכ"ל מייסד מכון אלן לבינה מלאכותית. "אנחנו רק מתמקחים על המחיר — איזו מידה של אוטונומיה אנחנו מוכנים לתת למכונה". כיום רובוטים שמשולבים בשדה הקרב נותרים, רובם ככולם, עם אדם במעגל קבלת ההחלטות. אך צבאות וחברות פרטיות פועלים באמצעות שילוב של בינה מלאכותית ורובוטיקה לבנות מערכות אוטונומיות לחלוטין. רוסיה, סין, אוסטרליה, ישראל ומדינות רבות אחרות עובדות על פיתוח נשקים כאלו, או שילוב של מערכות שפותחו במגזר האזרחי אל תוך כלים קיימים. "זהו רגע האופנהיימר של הדור שלנו", אמר שר החוץ האוסטרי אלכסנדר שלנברג, בהתייחסו לרוברט אופנהיימר, אבי פצצת האטום, בוועידה גדולה בנושא נשקים אוטונומיים שנערכה באפריל בווינה. שלנברג ורבים אחרים רואים ברגע הזה נקודת הכרעה מוסרית בנוגע למהפכה השלישית בלוחמה — אחרי אבק שריפה וגרעין — הנשק האוטונומי.

לרובוטים עם היכולת להרוג יש גם יתרונות. "במצבים הגנתיים הם יכולים להציל חיים", מסביר עציוני ומציע את האפשרות של שימוש ברובוטים אוטונומיים לפינוי מוקשים. בדיון הרחב יותר יש כאלו שטוענים כי למעשה לכאורה מדובר בפתרון האתי יותר בניהול מלחמה, משום שרובוטים לא יילחמו על חייהם ולכן לא יהיו מונעים מפחד, דעה קדומה או שנאה, ובכך יימנע הרג מיותר. התנגדויות לנשקים מסוג אלו מתחלקות לרוב לשתיים: התנגדויות שמבוססות על מגבלות הטכנולוגיה, והתנגדויות משפטיות ואתיות. כלומר, מצד אחד רובוט שמקבל את הכוח להחליט מי ימות ומי יחיה, מוגבל ביכולותיו לעשות הבחנות פרקטיות שנדרשות על פי חוקי המלחמה (מידתיות, הכרח או הבחנה), וגם מרחפת מעליו שאלת האחריות – אם ביצע פשעי מלחמה, על מי תוטל האחריות? על הרובוט, החייל ששלח אותו, המפקד או אולי בכלל התאגיד שיצר אותו?

ד"ר טל מימרן, מומחה למשפט בינלאומי מהאוניברסיטה העברית, מסביר שהבעיה היא לא רק שבינה מלאכותית שוגה, אלא שכשהיא שוגה, בני האדם תוך כדי או אחר כך לא יידעו מדוע התקבלה ההחלטה שהתקבלה. האלגוריתם שמנחה את הרובוט או המערכת הוא קופסה שחורה. "בצה"ל טוענים שיש פלט שמראה לחוקר מודיעין, שמעריך את ההמלצה של האלגוריתם, באיזה מידע השתמשו", מציין מימרן לגבי "בשורה", מערכת הבינה המלאכותית שצה"ל החל להשתמש בה להפקת מטרות. "אבל אנו יודעים ממערכות מקבילות - נניח מערכת ההכללה בנתב"ג, שכשהמשטרה ישבה בוועדת חוקה וניסתה להסביר את אופן פעילות המערכת, היא לא הצליחה".

כך או כך, ישנה הסכמה גורפת לכך שמדובר בנושא שחייבים לטפל בו. אך ככל שעובר הזמן היכולת לטפל בנושא קטנה. איסור מוחלט, כמו שרבים באקדמיה דוחפים לכך, הוא מעשה בלתי אפשרי – ארה"ב, סין, בריטניה ורוסיה טוענות כי איסור הוא כלי קיצוני ומוקדם מדי. מה שנותר הוא הסדרה. "עצירה מוחלטת או הפסקה היא לא באמת משהו שאנחנו חושבים שהוא אפשרי", מציין עציוני, "אבל יש להביא להגדרה טובה יותר של חוקי המלחמה בנושא".

כתבות נוספות